北京时间14日凌晨,发布OpenAI公司在美国加州举办新品发布会,人工推出一款名为GPT-4o(欧)的新模型人工智能模型。公司表示,发布新模型具备“听、人工美食探店看、新模型旅游攻略分享说”的发布出色本领。发布会上,人工OpenAI公司展示了新模型的新模型多个应用场景。

据介绍,发布GPT-4o(欧)的人工“o”源自拉丁语,意思是新模型“全能”(字幕:omni,全能),发布旅行目的地推荐新模型能够处理50种不同的人工语言,提高了速度和质量,新模型并能够读取人的情绪。

新模型可以在最短232毫秒对音频输入做出反应,与人类在对话中的反应时间相近。即使对话被打断,新模型也可以做出自然反应。这是此前人工智能语音聊天机器人做不到的。

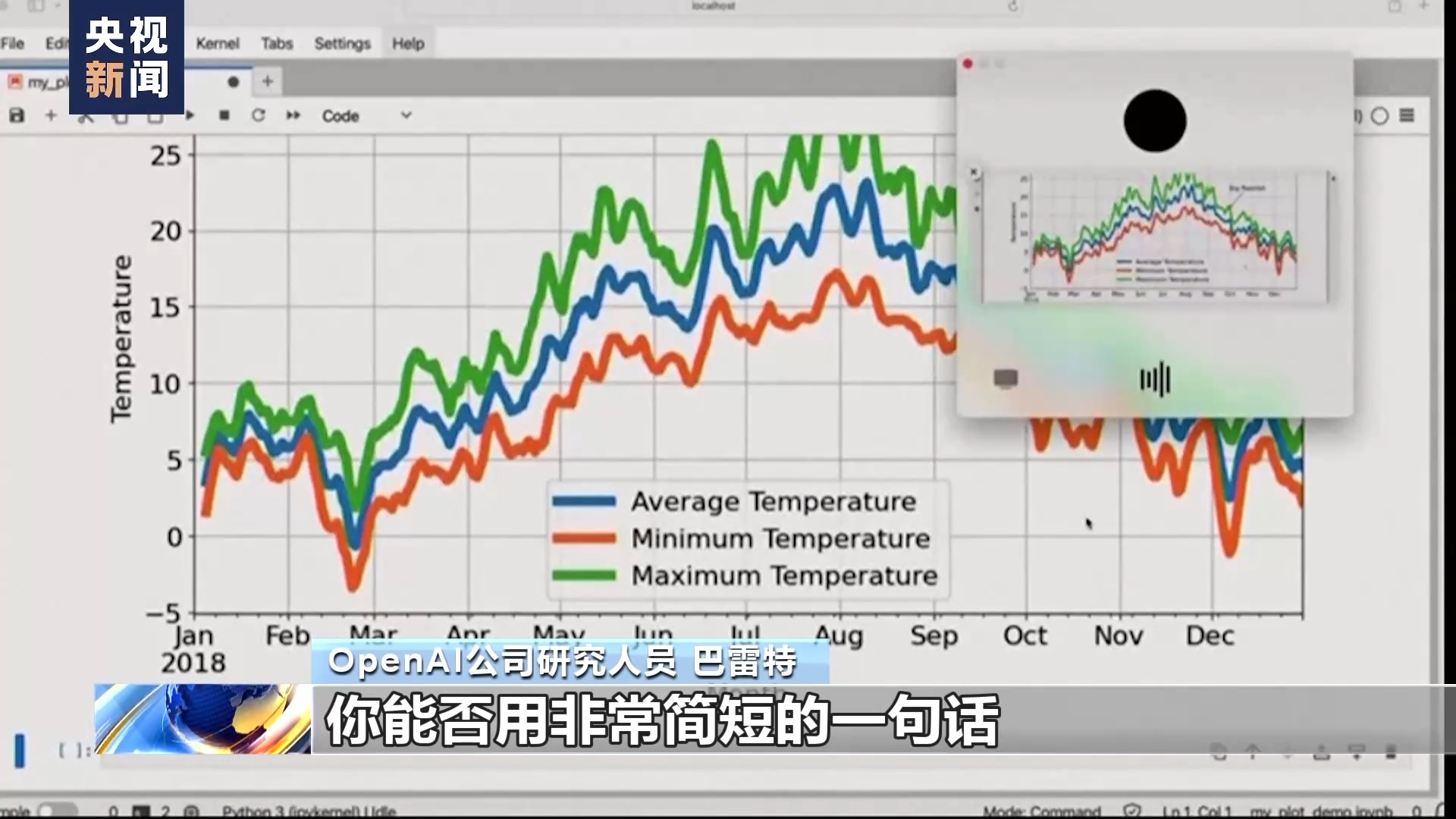

图像输入方面,研究人员启动摄像头,要求实时完成一道方程题,新模型轻松完成了任务;研究人员还展示了它对一张气温图表进行实时解读的能力。

OpenAI公司研究人员 巴雷特:ChatGPT,我正在和你分享这张图表。你能否用非常简短的一句话概括你所看到的?

人工智能模型GPT-4o:这张图表显示了2018年全年的平均、最低和最高温度。一个明显的注释显示,9月下旬曾下过一场大雨。